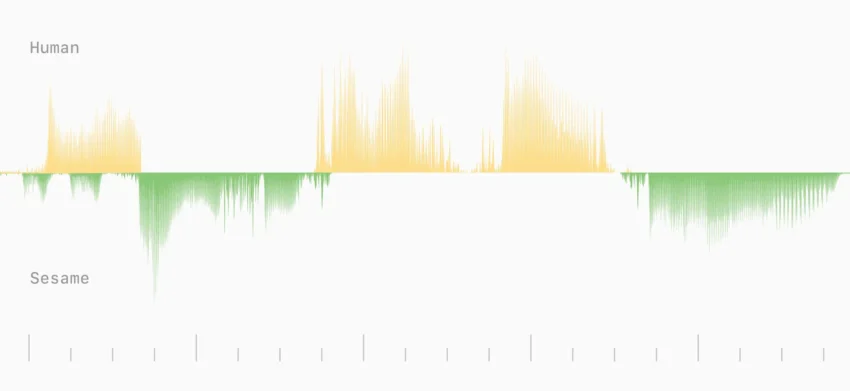

从今天上午Sesame的线上发布会开始,业界首次见到一套声线能够 即时捕捉情绪、自然停顿并维持一致人格 的对话语音系统。这套名为 Conversational Speech Model(CSM)的模型,以端到端多模态Transformer为核心,直接在 RVQ(Residual Vector Quantization)音频令牌上进行推理,实现了 单阶段、低时延的高保真语音生成。对AI眼镜等佩戴式设备而言,摆脱传统语音助手单调中性的“机械声”,意味着在日常使用中,设备能够像身边的真人伴侣一样,依据情境调节语调、节奏乃至情感温度,从而显著提升用户黏性与使用时长。

Sesame团队指出,真正的语音交互不仅是文字到声音的转换,更是 情感智能、对话动态、情境感知与人格一致性 四大要素的协同。为此,CSM在训练阶段引入了超过一百万小时的公开音频数据,并在模型规模上提供了 Tiny(1B+100M)、Small(3B+250M)和 Medium(8B+300M)三档选择。实验数据显示,Medium 版在 同音异义词辨识(Homograph Disambiguation) 上达到了 92% 的准确率,显著超越主流商业 TTS 系统的 78%‑85% 区间;在主观 CMOS 评测中,加入上下文后,人类听众对 CSM 的偏好率提升至 58%,虽仍低于真人录音,却已突破“自然度饱和”瓶颈。

技术细节上,CSM 采用两层 Llama‑架构的 Transformer:首层在 零码本(zeroth codebook) 同时处理文本与音频 token,捕获跨模态的语义与情感线索;次层解码其余 N‑1 码本,实现细粒度的声学细节重建。为缓解训练时的显存压力,团队创新性地 仅在 1/16 的音频帧上训练音频解码器,却未出现可感知的质量下降。此种“计算摊销”方案为后续更大规模模型的迭代提供了可行的路径。

对 AI 智能眼镜的意义尤为显著。当前多数可穿戴设备的交互仍依赖文字输入或冷冰冰的语音指令,情感缺失导致用户快速产生使用倦怠。Sesame 的 CSM 通过实时情绪感知与自然停顿,使得眼镜能够在会议记录、导航提示乃至社交场景中,以更贴合人类对话节奏的方式提供信息。例如,在嘈杂的户外环境下,眼镜可以自动降低语速、加重强调关键词;在用户情绪低落时,声音会自带安抚的温度,降低交互摩擦。

然而,技术落地仍面临几大挑战。首先,CSM 目前仅在 英语语料上训练,多语言扩展仍属“传闻”,需要在全球化市场中进一步验证;其次,隐私合规是可穿戴语音交互不可回避的门槛——实时捕捉情感的模型必然涉及更细粒度的用户数据收集,欧洲 GDPR 与美国州级法规对本地化推理提出了更高要求。Sesame 已在发布会中承诺,模型将采用 本地化推理+端到端加密 的双轨方案,以兼顾体验与合规。

展望未来,Sesame 计划在 六个月内开放模型代码(Apache 2.0 许可证)并同步提供 多语言训练脚本,鼓励社区在不同硬件平台上进行适配。若行业能够在硬件(低功耗 NPU、麦克风阵列)与软件(情感语音模型)之间形成闭环,AI 眼镜的交互体验将从“功能性工具”跃升为 “情感伴侣”,这正是下一波可穿戴创新的核心竞争力。

结语:Sesame 的 CSM 为语音交互注入了久违的情感温度,为 AI 眼镜等可穿戴设备打开了“声线存在感”的可能性。随着模型规模、语言覆盖与隐私合规方案的逐步完善,真正的情感 AI 伴侣或将在不久的将来进入千家万户。

参考来源

- Sesame 官方博客:《Crossing the uncanny valley of conversational voice》(2025‑02‑27)

- 論文《Conversational speech generation》, arXiv:2306.12925, 2107.03312 等

- CSM 评测报告(内部发布)